Google’s DeepMind-Team präsentiert eine bahnbrechende KI-Technologie namens V2A (Video-to-Audio), die die Erstellung von Soundtracks für Videos automatisiert. Hier die wichtigsten Punkte:

- Funktionsweise: V2A generiert Musik, Soundeffekte und Sprache basierend auf Textanweisungen und Videoinhalten.

- Vielseitige Anwendung: Einsetzbar für KI-generierte Videos, aber auch für bestehendes Material wie Archivaufnahmen oder Stummfilme.

- Flexible Steuerung: Nutzer können positive und negative Textanweisungen geben, um den Soundtrack präzise zu gestalten.

- Pixelbasierte Generation: Die KI kann auch ohne Textanweisungen arbeiten, indem sie nur die Videobilder analysiert.

- Aktuelle Grenzen: Die Audioqualität hängt von der Videoqualität ab, und die Lippensynchronisation ist noch nicht perfekt.

- Zukunftsaussichten: DeepMind arbeitet an der Verbesserung dieser Aspekte.

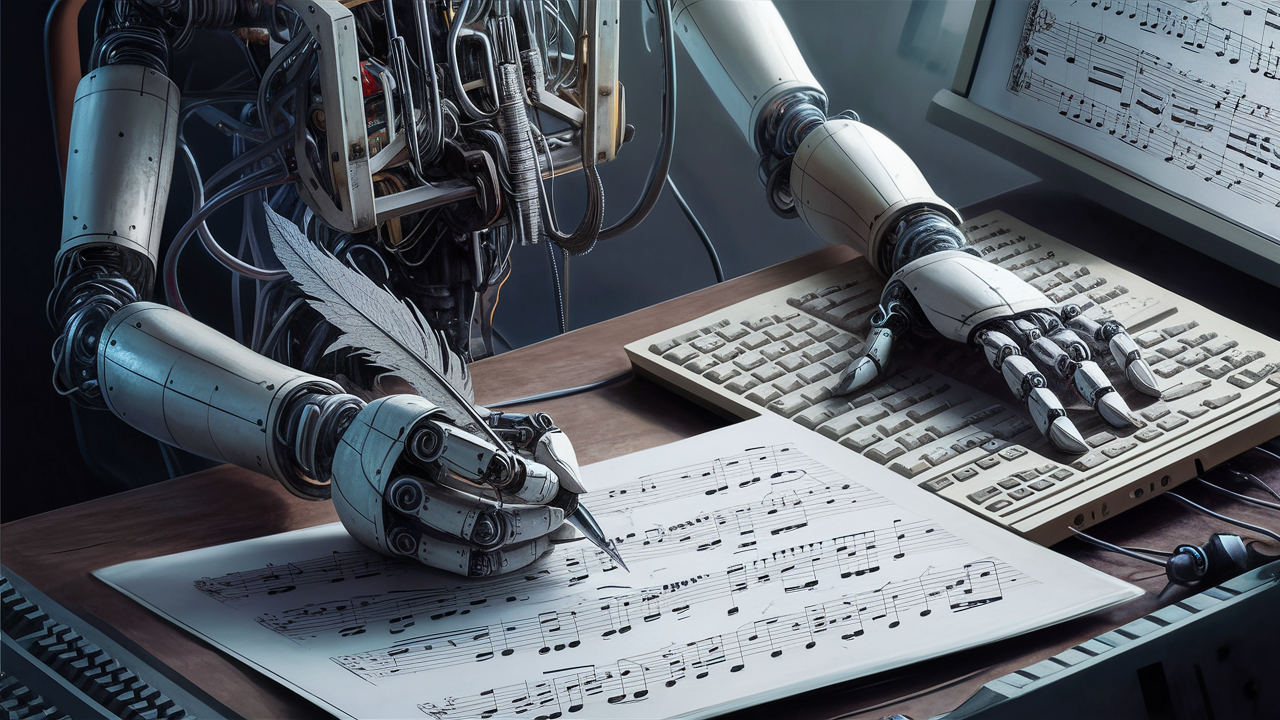

Diese Entwicklung könnte die Arbeit von Komponisten für Filmmusik grundlegend verändern. Sie eröffnet neue Möglichkeiten für die schnelle und kostengünstige Produktion von Videosoundtracks, wirft aber auch Fragen zur Zukunft menschlicher Kreativität in diesem Bereich auf.

Die V2A-Technologie zeigt einmal mehr, wie KI traditionelle kreative Prozesse revolutioniert und die Grenzen zwischen menschlicher und maschineller Kunstfertigkeit verschwimmen lässt.

Link: V2A @ Google Deepmind

Entdecke regelmäßig frische Inspirationen für deine kreative Arbeit!

Abonniere jetzt den otticcreative signals Newsletter für News, Ideen und digitale Tools.